Lecture 3 : Bayesian Decision Theory (1)

CONTENTS

- Bayesian Decision Theory

- Generalized Bayesian Decision Theory

Classification

Unknown Input(X)가 주어졌을 때, 예측 모델(classifier)를 사용하여 Y를 예측해내는데, 이 때의 Y는 label로

discrete value이다. output이 continuous하던 linear regression과는 달리 output이 discrete하다.

Probabaility Review

Conditional Probability

x2라고 가정하였을 때, x1이 나올 확률

ex) P(banana | Yellow) => 해당 과일의 색이 Yellow일 때 그 과일이 banana일 확률.

보통 P(label | input) 으로 어떠한 input을 넣었을 때 특정 label이 나올 확률과 같은 방식으로 구한다.

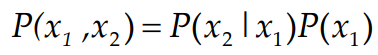

Joint Probability

input feature vector가 두개의 variable을 갖을 때, 두 variable 모두 만족 시켜주는 확률

ex) P(10cm, yellow) => 해당 과일의 길이가 10cm이고 색깔은 yellow일 확률

Conditional Probability와 Joint Probability의 관계식

Bayesian Decision Theory

확률론적인 접근(probabilistic approach)를 통하여 리스크(또는 cost)를 최소화 시켜주는 결정을 내린다.

Prior Probability : 측정 및 관측을 통해서 미리 결정되는 것이다. 주어진 dataset중에서 해당 class에 속하는 것이 얼마나

존재하는지에 대한 확률

feature vector => input으로 주어지는 vector 값. 해당 class에 속하는 instance들의 attribute들로 다차원이 될 수 도있

다. ex) length, mass, height, color...

class conditional density : empirical pdf로 histogram으로 표현된다. 특정 class에 속하는 instance들의 분포를 알려준다.

Posterior probability : 어떠한 feature vector(input 값)가 주어졌을 때, 그 input이 속할 클래스의 확률.

ex) [15cm, yellow] 라는 feature vector를 같는 instance가 바나나일 확률 or 사과일 확률 or 수박일 확률....

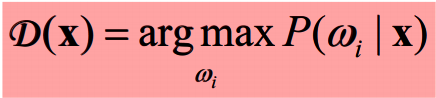

따라서, Bayesian formula와 Decision Rule을 결합하여 분류를 해야하는 문제를 해결할 수 있다.

Posterior Probability를 가장 크게 만들어줄 때의 class를 선택해줘야하는데 이를 직접적으로 구할 수가 없다. 따라서,

위와같이 class conditional density, 혹은 Likelihood function을 이용하여 문제를 해결한다.

이때, p(x)는 모든 class에 대하여 같은 값을 갖기 때문에 무시해준다.

따라서 Posterior probability를 최대화 시켜줄 때의 class w를 선택해준다.

결국 Posterior Probability를 비교하는 것은 likelihood function x Prior Probability를 비교하는 것과 같다.

만약 각 클래스들의 발생확률 (Prior Probability)가 모두 같다면, likelihood function만 비교하는 것만으로도

decision을 내릴 수가 있다.

Decision Based On Minimum Error

위의 과정이 Posterior Probability를 최대화 시켜주는 것을 기반으로한 decision making이었다면,

error를 최소화 시켜주는 관점으로 decision을 위한 식을 재정의 할 수 있다.

p(error, x)는 x라는 input이 들어오고, 동시에 error가 발생할 확률을 의미한다.

ex) w1과 w2 로 두가지의 class만 존재하는 경우

Maximizing posterior probability 또는 minimizing the error라는 다른 용어만 사용할 뿐이지 결국엔

같은 소리는 하는 것이다.